Willkommen auf unserer Infoseite zur Nutzung von Höchstleistungsrechnern! Hier finden Sie Informationen zu verschiedenen Themen im Kosmos Höchstleistungsrechnen.

Bitte beachten Sie: Diese Seite sammelt Links und Informationen zu spezifischen Themen. Wenn Sie individuelle Fragen haben oder grundlegendere Informationen benötigen, besuchen Sie unsere Seite zu Trainings oder nutzen Sie unser Kontaktformular.

HPC Zugang

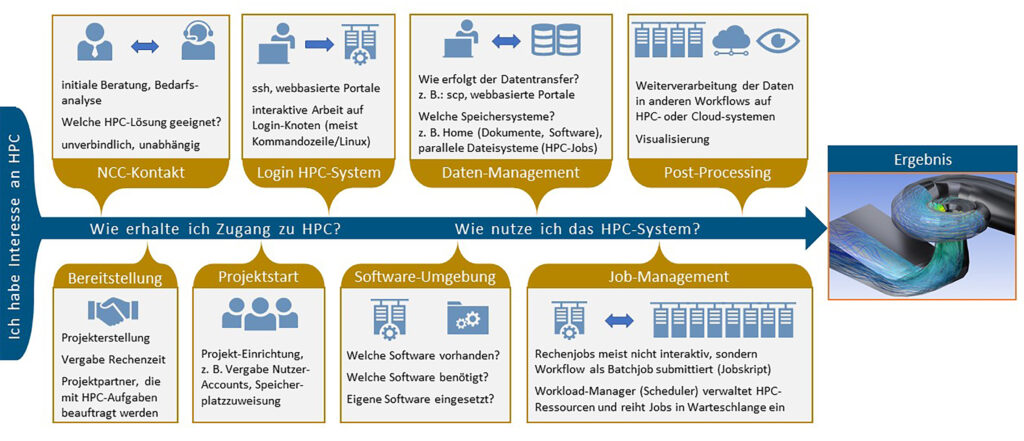

HPC-Ressourcen – typischerweise in core-hours angegeben – sind nicht nur für die Wissenschaft, sondern auch für KMU, Industrie und den öffentlichen Sektor verfügbar. Für Wissenschaftler:innen besteht die Möglichkeit, HPC-Ressourcen aus öffentlichen Fördermitteln zu beantragen. Erklärungen hierzu sind in dieser Kategorie verlinkt. Nutzer:innen außerhalb des wissenschaftlichen Sektors beraten wir gerne hinsichtlich der Zugangsmöglichkeiten – kontaktieren Sie uns einfach über das Kontaktformular.

Sobald die HPC-Ressourcen gewährt sind, können die Systeme genutzt werden. Je nach Bedarf und Erfahrung geschieht dies entweder klassisch über die Kommandozeile per gesicherter Verbindung durch Secure Shell (ssh) oder auch interaktiv, beispielsweise gesichert über JupyterLab. Der Login geschieht typischerweise über ein Frontend, von dem aus dann sogenannte Jobs abgeschickt werden, in denen die vom User definierten Arbeitsaufträge mit den angeforderten Ressourcen (Rechenknoten / Cores, Dauer) abgearbeitet werden. Sowohl die Jobs als auch das gesamte Projekt können durchgängig überwacht werden (Job Monitoring, User Portal). Erklärungen und Beispiele zum technischen HPC-Zugang sind nachfolgend aufgeführt.

JSC | LRZ | HLRS |

Voraussetzungen: (Rechenzeitprojekt, JUDOOR-Account), Anleitung SSH-Login, GUI per X-Forwarding, Putty, VNC: JUWELS, JURECA oder via JupyterLab (Folien und Video) Job-Monitoring und Nutzer-Portal Nutzungsbeispiel: Deep Learning on Supercomputers – An Introduction (MNIST Tutorial mit Keras/Tensorflow, Anpassung für Distributed Training (Horovod), (GIT repo) | Projekt: Am LRZ können Projekte ausschließlich durch akademische Einrichtungen, jedoch mit Industriebeteiligung (Projektpartner), beantragt werden. Projekt-Antrag: Supercomputer Linux Cluster Wie weiter nach der Bewilligung? Guide Projekt-Bewilligung (GCS) Guide Projekt-Bewilligung (PRACE) | Hawk Platform: HPE Hawk access – HLRS Platforms HPC-Zugang : SSH-Login über klassische Konsole mit fester IP-Adresse Vulcan Platform: NEC Cluster access (vulcan) – HLRS Platforms HPC-Zugang: SSH-Login über klassische Konsole mit fester IP-Adresse |

SSH: SSH at LRZ HPC systems SSH Tutorial + Video Überblick und Status der HPC-Systeme Nutzer-Portal Graphisch aufbereitetes HPC-Job-Monitoring: Portal, Dokumentation | ||

Arbeitsumgebungen: Compute Cloud: Zugangsinformationen, Präsentation Überblick Jupyter in der Cloud VNC: Nutzung eines serverseitig vorkonfigurierten Remote-Desktops auf dedizierten Knoten des Linux Clusters oder Supercomputers |

Software

Ohne Software kein High Performance Computing, AI oder Cloud Computing! Moderne HPC-Systeme unterscheiden sich deutlich von Computern aus dem Consumer-Bereich hinsichtlich ihrer Architektur (z. B. Art und Anzahl der Rechenkerne, Größe des Arbeitsspeichers), der Speichermedien und vor allem der meist komplexen Netzwerktopologie. Daher kommen auf die HPC-Systeme angepasste Betriebssysteme zum Einsatz. Auf deren Grundlage wird den Nutzer:innen ein breites Software-Portfolio bereitgestellt. Das umfasst einerseits auf das HPC-System abgestimmte Basis-Software wie z. B. Compiler oder Kommunikationsbibliotheken für paralleles Rechnen, und andererseits die HPC-Anwendungen wie z. B. Simulationssoftware und wissenschaftliche Bibliotheken. Das Software-Angebot steht den Nutzer:innen üblicherweise über ein Modulsystem zur Verfügung. Software-Komponenten in den gewünschten Versionen können zusammengestellt und in Rechenjobs eingesetzt werden.

Das Angebot umfasst neben Open-Source-Paketen und Community-Anwendungen auch kommerzielle Software. Darüber hinaus steht es den Nutzer:innen frei, Software-Pakete oder selbst-entwickelte Programme in ihr privates Verzeichnis zu installieren. Auf Wunsch kann Software auch in das Portfolio aufgenommen oder auch Unterstützung bei der Installation und Konfiguration auf dem HPC-System geleistet werden.

Erklärungen und Beispiele zu Software sind nachfolgend aufgeführt.

JSC | LRZ | HLRS |

Bereitgestellte Software-Umgebung: Modulsystem und Spack: Dokumentation, Präsentation Überblick | Application software packages – HLRS Platforms | |

Interaktive HPC/Entwicklungsumgebung JupyterLab (Überblick) | Spack im User-Space zur eigenen Software-Installation durch Nutzer:innen | |

Software mit Remote-Access-Funktionalität, z. B.: Visual Studio Code, Matlab |

Datenmanagement

In HPC-Projekten entstehen typischerweise große Mengen an Daten. Speichersysteme mit anforderungsgerechten Eigenschaften gewährleisten bei der Handhabung dieser Daten eine optimale Leistung. Beispielsweise ermöglichen parallele Dateisysteme ein schnelles, paralleles Lesen und Schreiben von Daten während eines HPC-Jobs, welche zur dauerhaften Sicherung in Langzeit-Archive bewegt werden können. Erklärungen zu den verschiedenen Speichersystemen und deren Nutzung, sowie die Möglichkeiten des Datentransfers zwischen verschiedenen Dateisystemen sind in dieser Kategorie verlinkt.

JSC | LRZ | HLRS |

Eigenschaften und Verwendung der Dateisysteme: Supercomputer, Linux Cluster Data Science Storage Data Science Archive | ||

Datentransfer zwischen den Zentren bzw. Nutzer-Arbeitsplatz und Zentrum via Globus Online oder scp |

Visualisierung & Postprocessing

Wir unterstützen Ingenieur:innen und Wissenschaftler:innen, industriellen Nutzer:innen aber auch den öffentlichen Sektor bei der visuellen Analyse von Daten, die typischerweise durch Simulationen auf Hochleistungsrechnern erzeugt werden.

Hierzu können unterschiedliche Visualisierungsmethoden und -technologien aus unser Portfolio angewendet werden. Zur Visualisierung von Ergebnissen ist ein gesonderter Zugang zu dafür vorgesehenen Visualisierungsknoten notwendig.

Der Zugang erfolgt über Remote Desktop (über einen Webbrowser) oder Client-Server (Software erforderlich). Eine weitere Möglichkeit ist über VNC-Viewer (Software erforderlich) oder die Nutzung von JupyterLab (Webbroswer). Weitere Informationen und Dokumentationen finden Sie hier.

JSC | LRZ | HLRS |

Remote Visualisation 2021 als webbasiertes Frontend, Arbeit auf einem Remote Desktop: Portal, Dokumentation | Graphic Environment: VNC-Zugang: Graphic Environment – HLRS Platforms | |

Paraview in Rechenjobs (batch-Modus) oder zur interaktiven Arbeit auf Rechenknoten (Client-Server-Modus) | ParaView -> Anmeldung über Client: Hawk PrePostProcessing – HLRS Platforms | |